Vom Golden Batch zum regelmässigen Perfect Match

Industrielle Anlagen produzieren grosse Mengen an Daten. Das macht es schwierig, manuell alle relevanten Informationen zu analysieren und Unregelmässigkeiten zu erkennen. Die ControlTech Engineering und Learning Machines haben eine Reihe von KI-Tools entwickelt, die dabei helfen, Prozesse effizienter zu überwachen und komplexe Daten besser zu verstehen.

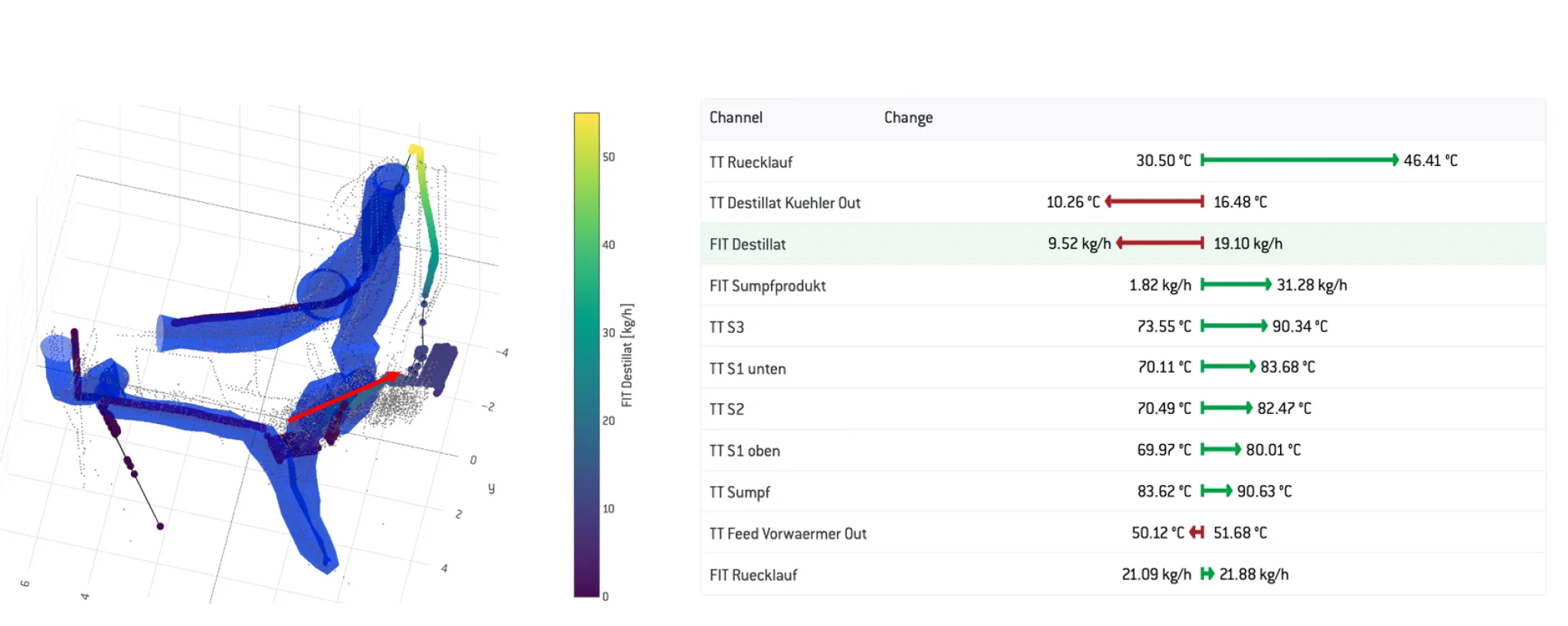

Bei Industrieanlagen können gleichzeitig zahlreiche Parameter gemessen werden. Je nach Grösse der Anlage sind das weit über hundert oder sogar tausend verschiedene Messkanäle. Eine manuelle Analyse dieser Datenmengen ist unmöglich. Hier sind automatisierte Systeme erforderlich, um die Daten in Echtzeit zu überwachen und Abweichungen frühzeitig zu erkennen. «Um die Daten besser verständlich zu machen, nutzen wir eine Technik, die als Einbettung bezeichnet wird.» erklärt Dr. Boris Lau, Geschäftsführer von Learning Machines. Diese Methode reduziert die hochdimensionalen Daten von zahlreichen Messkanälen auf drei Dimensionen. Da die Ähnlichkeiten zwischen den Datenpunkten erhalten bleiben, können Verläufe und Anomalien visuell dargestellt werden.

Der mehrfache Golden Batch als Schlauch zeigt den optimalen Durchgang. Im Video erklärt Dr. Boris Lau, wie der 3D-Quality-Schlauch funktioniert.

Die Einbettung erzeugt eine 3D-Darstellung der Daten in Form von einzelnen Datenpunkten. Auf Basis dieser Punkte wird ein Schlauch berechnet, der die Punkte von ausgewählten Batches einschliesst, und damit die idealen Prozesse in der Anlage modelliert. Abweichungen vom normalen Verlauf lassen sich leicht erkennen, sobald der Prozess den Schlauch verlässt. Normalerweise wird zur Überwachung unabhängig voneinander betrachteter Grenzwerte gearbeitet. Das Interessante an der 3D-Darstellung ist, dass diese Anomalien auch auf ungewöhnliche Kombinationen von Messwerten hinweisen. Dr. Boris Lau erklärt weiter: «Unsere Tools ermöglichen es, einzelne Datenpunkte und deren Veränderungen zu analysieren. Um die Abweichung zu verstehen, ist es möglich, diese Daten zu erkunden. Es wird nach Wichtigkeit der Veränderung angezeigt, welche Messwerte sich verändert haben. Diese detaillierte Analyse hilft, die Ursachen von Anomalien schnell zu identifizieren und zu beheben.»

Der mehrfache «Golden Batch» als 3D-Quality-Schlauch visualisiert

In der Industrie hat sich der Begriff «Golden Batch» etabliert. Er bezeichnet ideale Produktionsabläufe, die als Referenz für die Bewertung dienen. Die Einbettung durch 3D-Darstellung geht jedoch über die traditionelle Definition hinaus. Dabei werden mehrere «Golden Batches» genutzt, um ein umfassenderes Bild des normalen Betriebs zu zeichnen. Diese Referenz-Batches werden in die 3D-Darstellungen eingebettet. So lässt sich schnell erkennen, welche Faktoren für erfolgreiche Produktionsabläufe entscheidend sind – das ergibt sozusagen einen «Perfect Batch».

Intern sprechen die Entwickler vom «3D-Quality-Schlauch», der den mehrfachen «Golden Batch» und seinen Mehrwert visualisiert. Im Pilotprojekt für das Data Science Framework (DSF) an der FHNW in Muttenz sind spannende Erkenntnisse entstanden.

Durch das strukturierte und zielgerichtete Vorgehen mit kleinen und kurzfristigen Zielen kann selbst bei einem einfachen System wie der Rektifikationskolonne basierend auf Betriebsdaten Verbesserungspotential gefunden werden.

Unabdingbar ist bei der datenbasierten Optimierung, dass neben den Zielen die Systemgrenzen genau definiert werden. Ansonsten ist das Risiko, sich in Datenprojekten zu verlieren und zu verzetteln, zu gross.

Es gibt kein «Wunder-Tool» und keine magische Technologie, welche aus Rohdaten alle Aufgaben einfach lösen kann. Die Kontextualisierung der Daten, das heisst, den Daten entsprechend wichtige Betriebs-, Prozess- und Business-Informationen mitzugeben, ist entscheidend für den Erfolg. Hierzu ist der «Winning Factor» der Einbezug des Wissens der verschiedenen Fachexperten und, dass man die Kommunikationsbarrieren überwinden kann.

Neue Technologien wie KI resp. Machine Learning, Deep Learning etc. können helfen, die Komplexität soweit zu reduzieren und zu strukturieren, dass der Mensch danach bessere Entscheidungen treffen kann. Der Einsatz dieser Technologien muss aber sehr zielgerichtet erfolgen.

Kurz: Die Einbettungstechnologie revolutioniert die Analyse von hochdimensionalen Daten. Durch die Reduktion auf drei Dimensionen und die visuelle Darstellung von Anomalien können komplexe Daten verständlich gemacht werden. Prozesse werden also effizienter überwacht und optimiert. Der «Perfect Batch» geht weit über den traditionellen «Golden Batch» hinaus, indem er mehrere perfekte Durchläufe zeigt und so die kontinuierliche Verbesserung der Produktion ermöglicht. Diese fortschrittliche Analysetechnik ist ein unverzichtbares Werkzeug für die moderne Industrie.

Die intelligente Anlage ist die Vision des DSF-Teams

Auch bei der Umsetzung der Optimierungen sollte man auf verschiedene Faktoren achten: Oftmals ergeben sich auf organisatorischer Ebene bereits low-tech Massnahmen, die dem Betrieb helfen und zur Steigerung der Effizienz beitragen. Dies können angepasste SOPs sein, eine erweiterte Alarmierung oder hilfreiche Darstellungen für die QA-Abteilungen. Allein diese Massnahmen können schon helfen, im täglichen Betrieb bessere Entscheidungen zu treffen. Die Umsetzung dieser Massnahmen ist nicht wirklich komplex, bedarf daher auch weniger Investitionen und bringt bereits einen Gewinn.

In einem weiteren Schritt können Massnahmen zielgerichtet definiert und beurteilt werden, welche einen Schritt tiefer in den Betrieb der Anlage eingreifen. Dabei meinen wir Verbesserungen auf Betriebsebene wie Regler- oder Prozessoptimierungen. Die Optimierung selbst sehen wir weiterhin als konventionelles Projekt, das KI-Dashboard hilft aber bei der Entscheidung, welche Massnahmen den grössten Benefit haben wird.

Unsere Vision ist der Schritt hin zu einer adaptiven Anlage. Das heisst eine Anlage, welche selbstständig Entscheidungen anhand aktueller Betriebsdaten trifft. Wir sehen das Potential, sehen aber auch einen langen Weg vor uns, um einerseits die Komplexität einer solchen Umsetzung abschätzen zu können, andererseits aber zuverlässig ermitteln zu können, wie gross das Potential in Realität sein wird.

Was wir Ihnen aber versprechen können: Wir bleiben dran und würden uns freuen, wenn wir uns zusammen mit Ihnen auf diesen Weg machen!