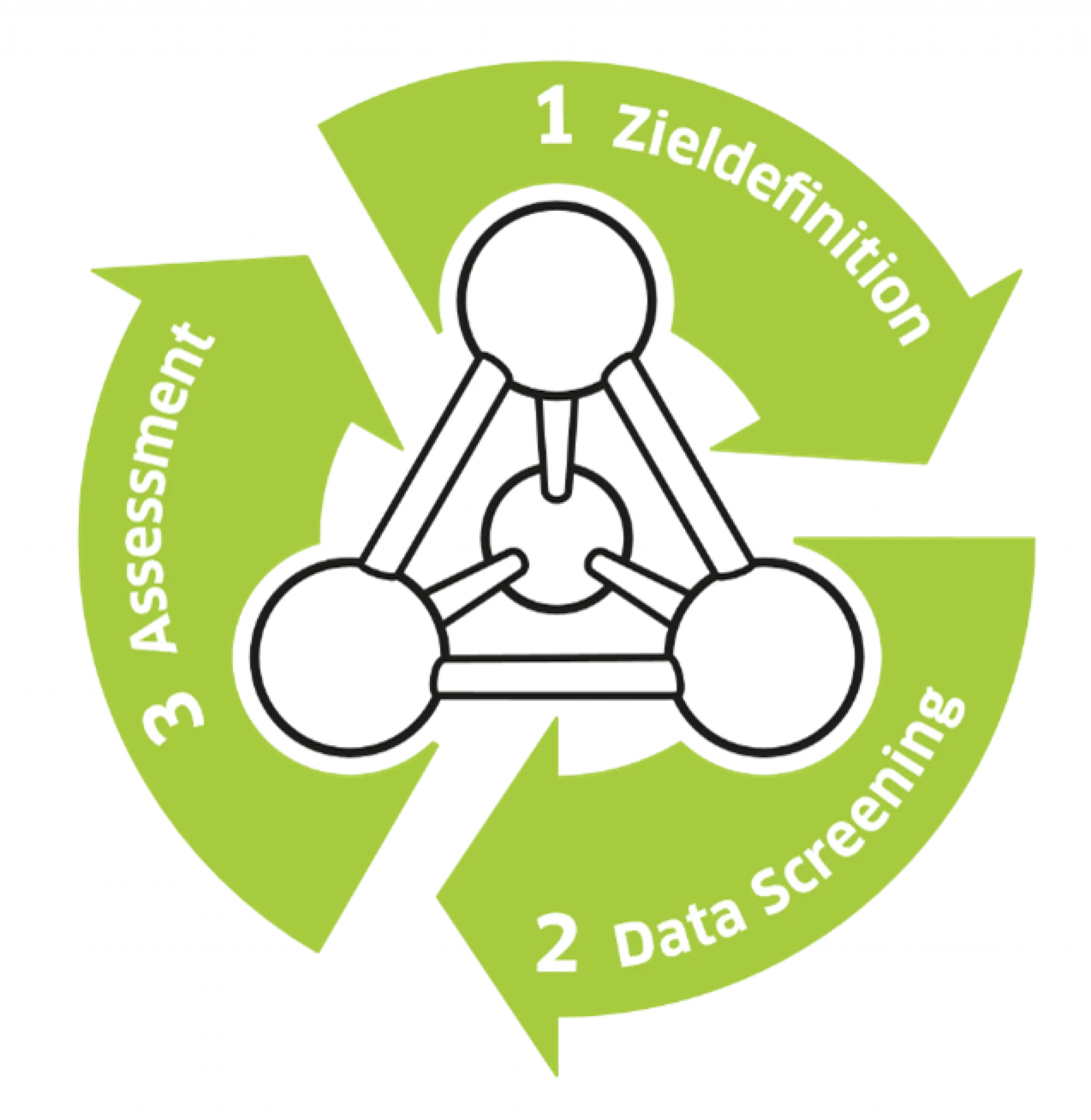

So funktioniert der Prozess für Data Science Projekte

Das Data Science Framework (DSF) der ControlTech Engineering AG unterstützt Unternehmen bei der Analyse ihrer Daten. Im standardisierten Prozess mit drei Schritten dreht sich alles um die richtige Zieldefinition, ums Data Screening und ums Assessment der Daten. Mit diesem Navigationssystem erreichen Sie Ihre Ziele.

Das Thema Data Science ist in aller Munde. Hier positioniert sich auch die ControlTech Engineering AG (CTE) aus Liestal. Stefan Kramberg informierte am Pharma Forum vom 25. April 2024 über ein Update unserer Arbeiten. Der Fachvortrag zum Thema Data Science Framework nahm bereits im Vorjahr das Thema Daten sammeln und analysieren auf. Wie wichtig die Kontextualisierung ist, zeigte aber die Fortsetzung von diesem Jahr: «Wir hatten das theoretische Modell, aber nicht genügend Daten. Zudem war die Datenqualität nicht ausreichend. Das sorgte für Unmut. Wir wollten in diesem Jahr unbedingt praktische Resultate zeigen», erklärt der Datenspezialist und Projektverantwortliche Stefan Kramberg.

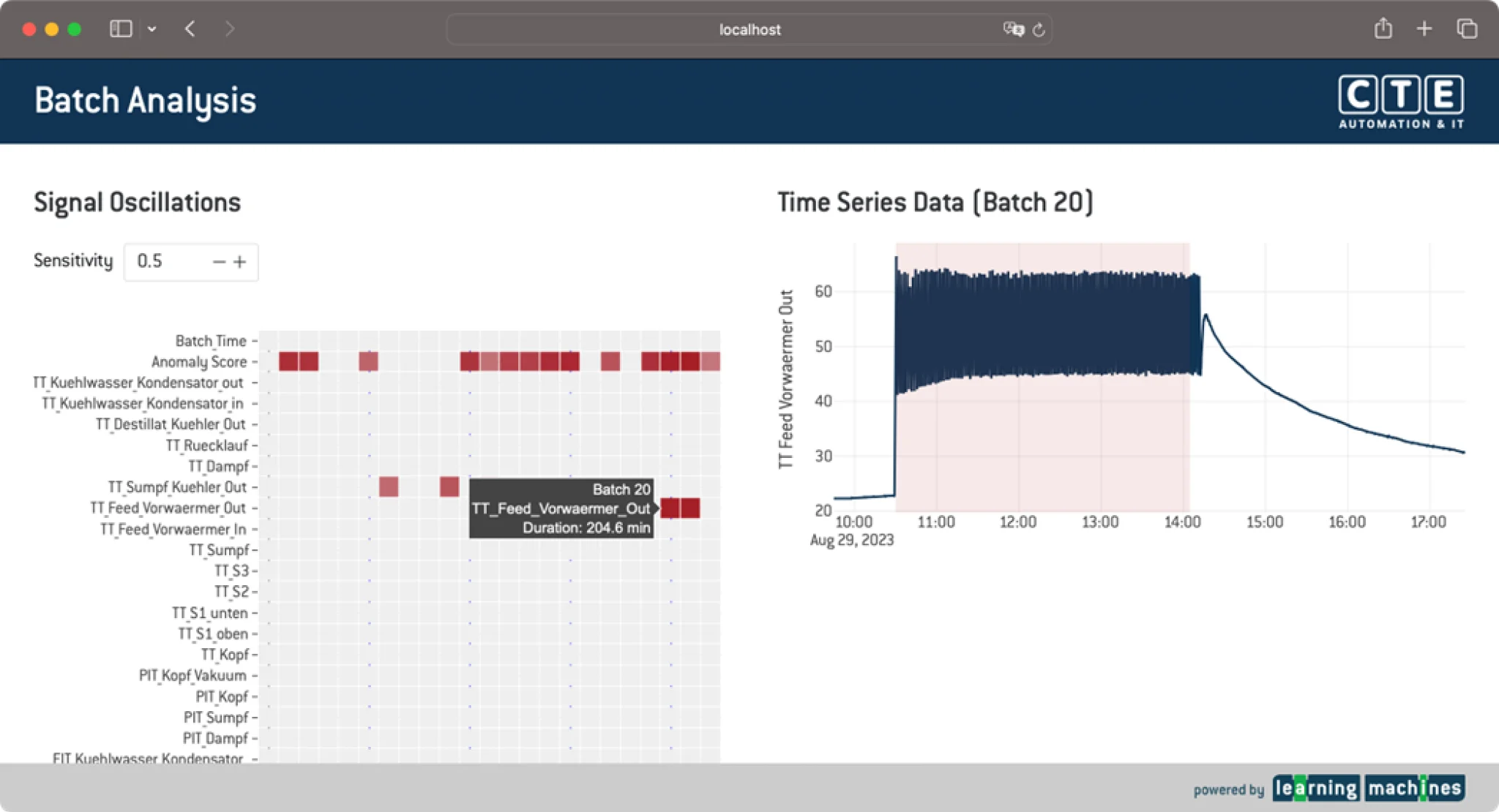

Anfang Jahr dann die erfreuliche Nachricht: «Wir haben es geschafft! Die Datenanalyse hilft uns, den Herstellungsprozess zu optimieren,» freute sich Stefan Kramberg. Das Pilotprojekt am Institut für Chemie und Bioanalytik der FHNW in Muttenz fokussierte auf eine Produktionsanlage, die nicht für den Markt produzierte. Sie steht aber dennoch sowohl von der Grösse wie auch von der Systemarchitektur einer produktiven Anlage in nichts nach. Demnach war sie flexibel für unseren Test einsetzbar. Als Basis wurde das Leitsystem PCS neo von Siemens eingesetzt, die Daten wurden mit dem AVEVA PI-System gesammelt und strukturiert.

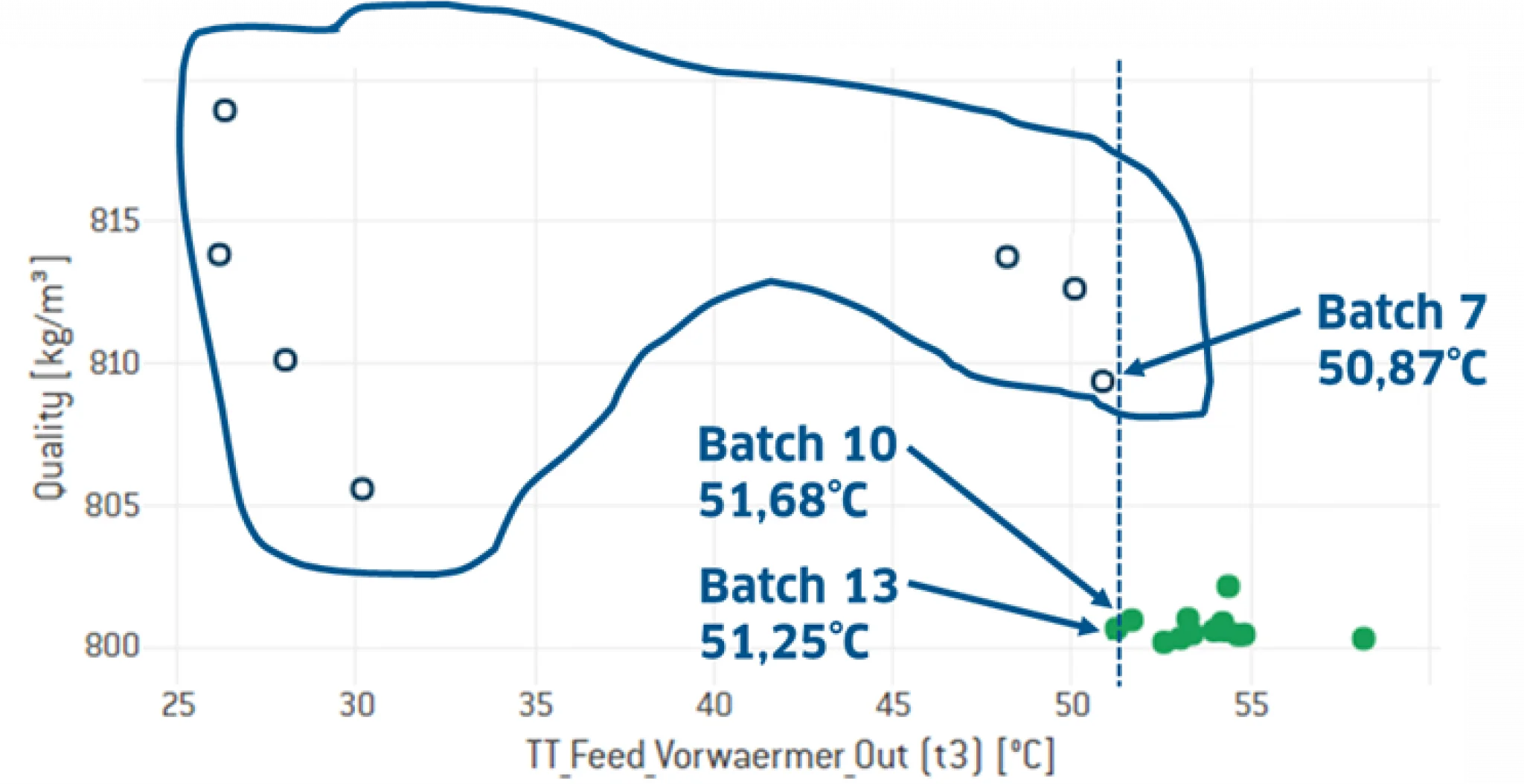

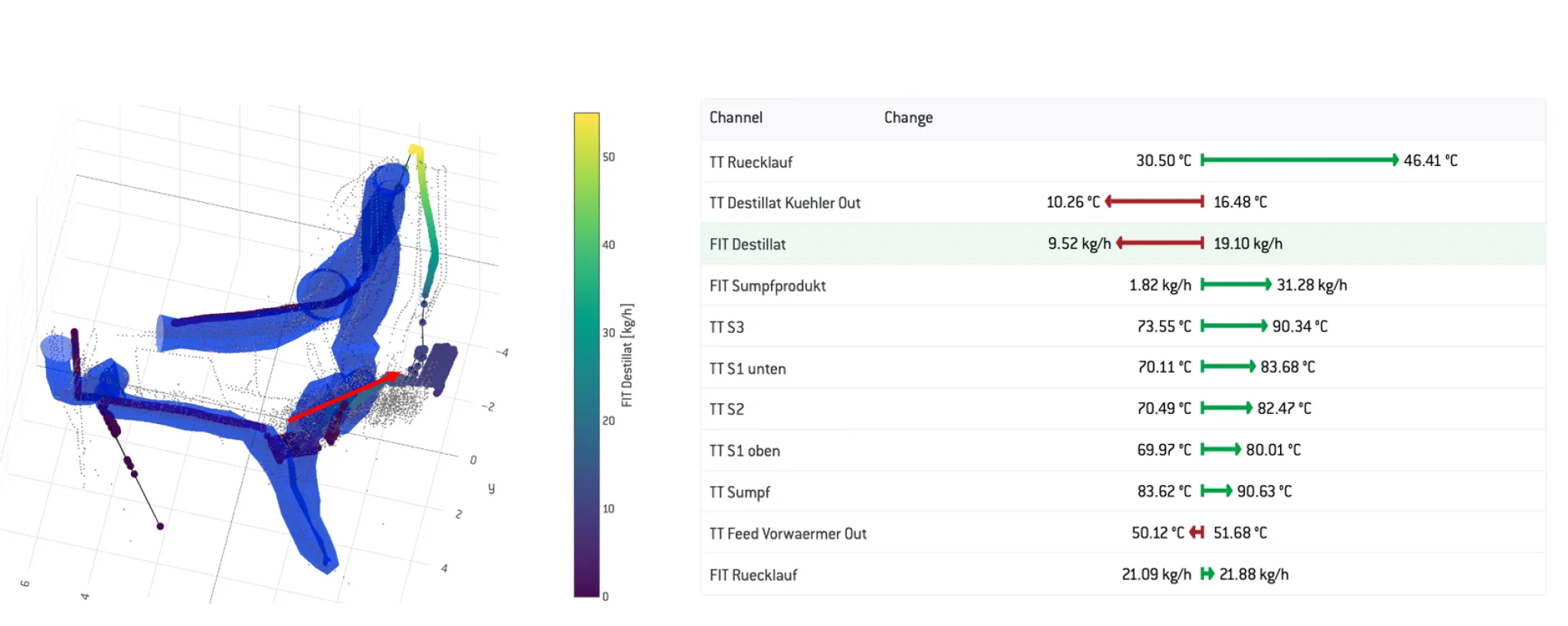

Die Zielsetzung war klar: Das Ethanol-Wasser-Gemisch sollte in Ethanol und Wasser getrennt werden, wobei Ethanol das Produkt und Wasser das Abfallprodukt darstellte. Der Auftrag im Pilotprojekt für die FHNW war, dass die ControlTech Engineering (CTE) eine Kostenreduktion durch Verbrauchsenkung in Bezug auf Dampf, Kühlmittel und Stickstoff erzielte. Zudem galt es die Qualität zu steigern. Hierzu wurde die Produktreinheit über die Dichte des Destillates gemessen.

So funktioniert das Data Science Framework im Use Case:

Zieldefinition: Ethanol und Wasser trennen

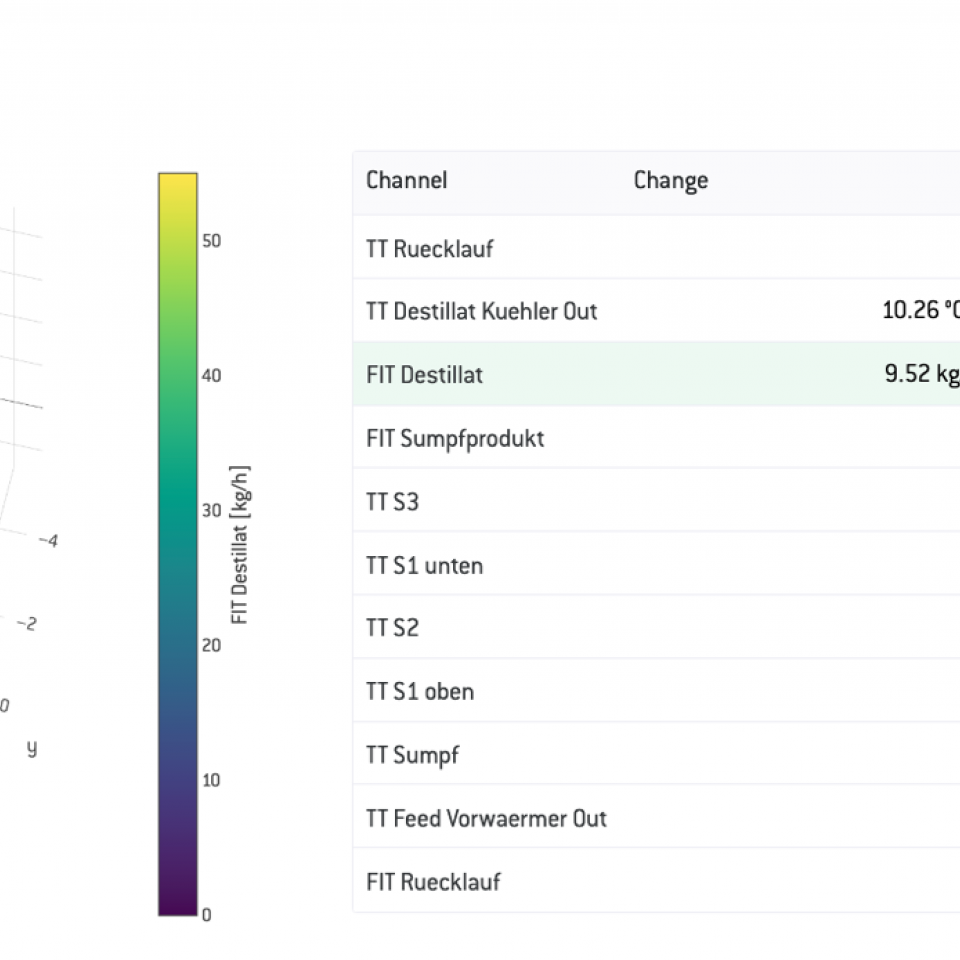

Data Screening: Prozessdaten zur Kontextualisierung in AVEVA PI AF implementiert

Assessment: zu wenig Batches / Daten, weitere Batches ab Q3 2023 vorhanden