Data Science Framework: Unser Navigationssystem zu Ihrer erfolgreichen data based Optimierung!

Würden Sie Ihren Herstellungsprozess anpassen, wenn Ihnen ein Chatbot Verbesserungsvorschläge macht? Nachdem ChatGPT immer mehr Einzug in unseren Alltag hält, wird sich auch die Pharma Industrie mit dem Umgang von künstlicher Intelligenz (KI) befassen müssen. In diesem Artikel zeigen wir Ihnen, wie unser Data Science Framework eine strukturierte Grundlage für Ihre Data Science Projekte schafft, um für eine mögliche Zukunft mit KI gerüstet zu sein.

Was lösen Buzzwords wie «Data Mining» oder «Machine Learning» aus?

Die Welt hat sich verändert. Was früher Zukunftsmusik war, ist im Jahr 2023 Realität. Neuronale Netze, deren Algorithmen so erschaffen worden sind, dass sie aus Situationen lernen können, bieten uns ungeahnte Möglichkeiten. Wir alle nutzen diese neuen Technologien wahrscheinlich bereits erfolgreich: So fragen wir unsere Smart-Watch nach dem Wetter, Feuerwehrleute üben Gefahrensituationen mithilfe von Virtual Reality und dank autonomer Fahrzeuge sind wir in unseren Autos nur noch Mitfahrer.

Wir gehen davon aus, dass das Thema «Künstliche Intelligenz» auch in unserer Branche eine immer wichtigere Rolle spielen wird. Aber zunächst müssen mithilfe von Data Science bewährte Grundlagen geschaffen werden, um den nächsten Schritt zur KI gehen zu können.

Brauchen wir in Zukunft den Faktor Mensch nicht mehr?

Natürlich spielt der Mensch noch immer eine wichtige Rolle im Thema «künstlicher Intelligenz». So auch in unserem CTE Data Science Framework. Lassen Sie uns Buzzwords wie «Data Mining», «Machine Learning», «neuronale Netze» oder auch «Artificial Intelligence» auflösen und auf Antworten eingehen, die das «Wie» erklären. Wie kommen wir zu künstlicher Intelligenz unter Berücksichtigung der behördlichen Anforderungen, welche in der pharmazeutischen Industrie gelten? So einfach ist das nämlich nicht.

Als Experten für Prozessautomatisierung treibt uns das «Wie» seit über 30 Jahren an. Automatisierte Lösungen gestalten unseren Alltag. Dieser Antrieb hat uns veranlasst, einen standardisierten Prozess zu entwickeln, der es uns erlaubt, mithilfe von «Data Science» datengetriebene Entscheidungen zu treffen. Wir sind überzeugt, dass die reine Datenspeicherung das Potenzial nicht ausschöpft. Wir sollten die Daten interpretieren, um die Schätze am Meeresgrund zu bergen. Lassen Sie uns gemeinsam abtauchen und herausfinden, wo Data Science auf dem Weg zur künstlichen Intelligenz einen Mehrwert schaffen kann!

Wo kann Data Science einen wirklichen Mehrwert schaffen?

Es geht nicht ums Wegrationalisieren von Arbeitsplätzen aufgrund künstlicher Intelligenz. Wir sind der Meinung, dass der Mensch weiterhin eine wichtige Rolle spielen wird, sich aber auf die wirklich wichtigen Dinge konzentriert. Menschen sind im Engineering in allen Phasen gefordert, beispielsweise um Grundlagen zu erarbeiten oder Entscheidungen zu fällen.

Data Science kann an anderen Orten Mehrwert schaffen: Bei der Automatisierung und Verbesserung der Qualität von Reportings und Nachweisen im GMP-Umfeld. Oder bei der Ermittlung und Speicherung von Prozess Know-how. Gerade bei spürbarem Fachkräftemangel oder wenn eine erfahrene Fachkraft das Unternehmen verlässt, geht Wissen verloren. Anders bei KI: Hat das neuronale Netz erst einmal gelernt, geht das erlernte Wissen nie wieder vergessen.

Mit unserem Data Science Framework schaffen wir die Grundlage für eine datenbasierte Optimierung der gesamten Herstellungs- resp. Betriebsprozesse. Denn bevor eine datenbasierte Optimierung überhaupt umgesetzt werden kann, müssen Daten erhoben, gespeichert, kontextualisiert und in Beziehung gesetzt werden.

Als Experten für die industrielle Automatisierung von Produktionsanlagen fokussieren wir darauf, den Mehrwert zu erkennen. Sei es im Herstellungsprozess oder in den Nebenprozessen bzw. -tätigkeiten. Es geht darum, ungeahnte Potenziale zu entfalten und wertvolle Zeit einzusparen. Ihre Rentabilität sowie die Sicherheit in den Prozessen ist unsere Kernaufgabe.

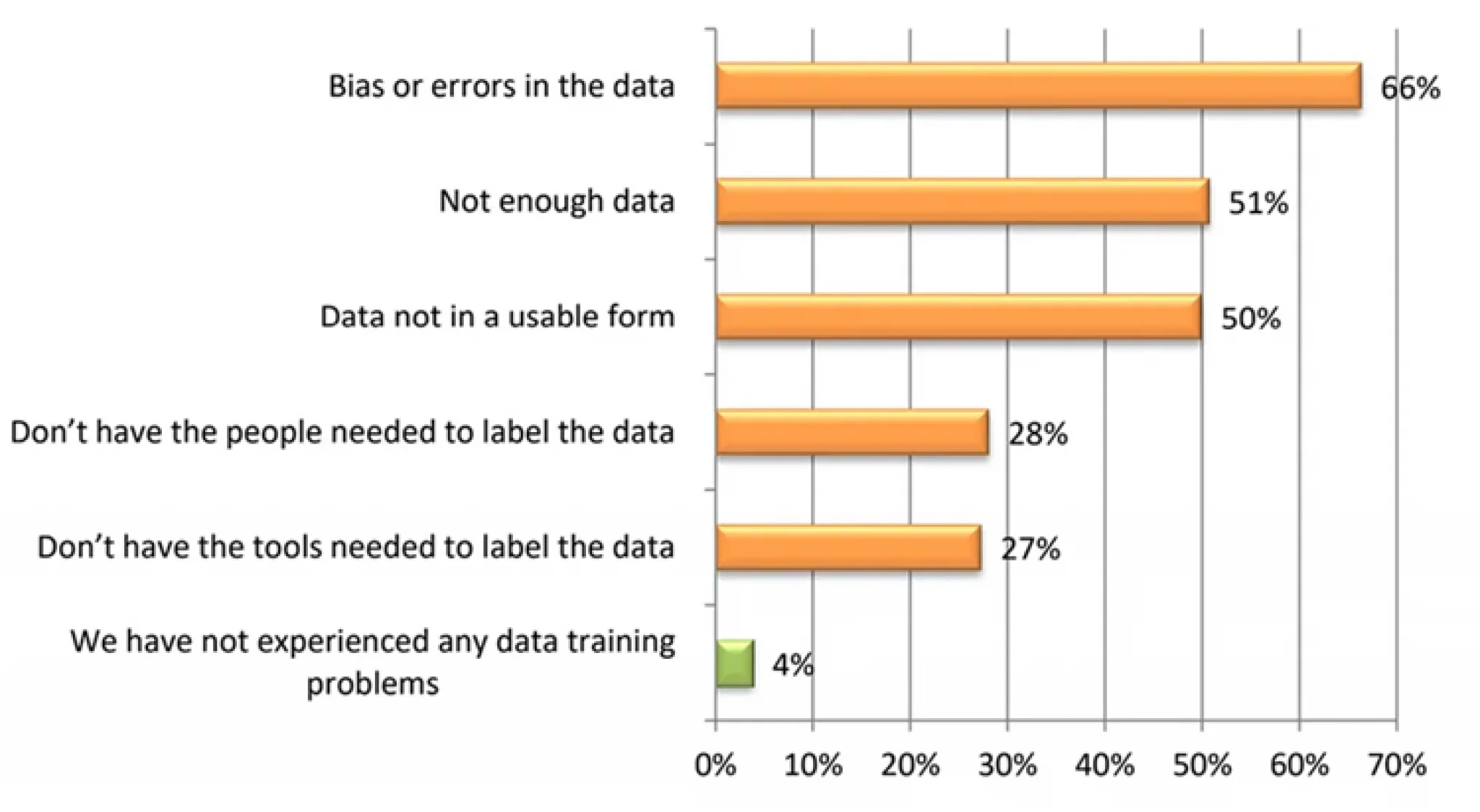

Aktuelle Zahlen einer Studie von Dimension Research Study zeigen die drei häufigsten Probleme, mit denen sich Unternehmen im Zusammenhang mit Daten konfrontiert sehen: “Fehler in Daten” (66%) “Nicht genug Daten” (51%) und “Daten nicht in geeigneter Form “ vorhanden (50%).

Darüber hinaus hat McKinsey ermittelt, dass 45% von grossen IT-Projekt aus dem Kostenrahmen laufen. Um dieser Tendenz zu begegnen, sieht unser Ansatz vor, nicht alles auf einmal anzureisen, sondern die gesetzten Ziele iterativ umzusetzen. So werden einerseits erste Ziele und vielleicht bereits wertvolle Erkenntnisse früher erreicht und andererseits damit der Aufwand überschaubarer sowie möglicherweise sogar mit den ersten Erkenntnissen Kosten eingespart.

Unser CTE Data Science Frameworks soll Sie in Ihrem IT-Projekt unterstützen und Ihnen Arbeit abnehmen, damit Sie sich auf die Inhalte und Ihre Projektziele konzentrieren können.

Zugegeben – um Rocket-Science handelt es sich hierbei nicht unbedingt. Aber auf dem Weg von Big Data über Data Science bis hin zur künstlichen Intelligenz sind diese Schritte essenziell. Die Pharma Industrie hat einen riesigen Vorteil: Sie sammelt bereits über viele Jahre hinweg Daten, da dies seitens Behörden gefordert wird. Nun liegen eben diese Daten als Schatz auf dem Meeresgrund und sollen als solcher geborgen werden. Stellen Sie sich vor, welche neuen Erkenntnisse Sie mit Ihren Daten gewinnen könnten?

Wenn wir das Framework für Ihr Projekt gemeinsam definiert haben, halten sie ein Dashboard in der Hand, auf dem Sie Zusammenhänge ganz einfach ablesen können. Bisher sind Ihre Daten möglicherweise in Form von Exceltabellen, Textdateien oder gar als Ausdrucke wohl eher unübersichtlich. Das Schöne an unserem CTE Data Science Framework: Es liefert nach jeder Iteration ein Ergebnis, bei dem Sie entscheiden, nach welchem Durchlauf das Ende erreicht ist. Sie können aber auch jederzeit wieder die Arbeit aufnehmen, um am bestehenden Ergebnis anzuknüpfen.

Gerade im GMP-Umfeld – also im stark regulierten Umfeld – scheint die Hürde mit den zu erfassenden Daten auch zu arbeiten höher zu sein als vielleicht in anderen Branchen… Aus diesem Grund erhält KI oft gar keine Chance. Zu Unrecht! Unser Ziel ist es, den Nutzen dieser Daten zu steigern und evtl. eines Tages damit den KI-Algorithmen eine Chance geben können, ungeahnte Erkenntnisse aufzudecken.

Lassen Sie uns in ein Pilotprojekt starten, um Vorreiter für das GMP-Umfeld zu werden!

Wir haben Argumente, wir haben das CTE Data Science Framework, wir brauchen nur noch reale Daten aus dem GMP-Umfeld. Wir wollen unsere Theorie in die Praxis transferieren. (GMP) Kunden zu finden, die mit uns ein Pilotprojekt starten wollen, ist aber gar nicht so einfach. Zu teuer, zu aufwendig, zu wenig Outcome, zu viele Anwendungsfehler waren nur einige der Argumente, die gegen unser Pilotprojekt sprachen. Aber wir sind überzeugt, dass «Data Science» mit unserem CTE Data Science Framework den Weg zur künstlichen Intelligenz ebnet.

Ziel eines Pilotprojekts mit Ihnen ist die Durchführung unseres Data Science Frameworks, von der Zielformulierung bis zur Anwendung bzw. Optimierung der Daten. Darüber hinaus wollen wir ermitteln, wie die datenbasierte Optimierung im regulierten Umfeld weiter automatisiert werden kann.